Cuando una sola opinión ya no es suficiente

Recuerdo vívidamente las primeras interacciones con ChatGPT a finales de 2022. La sensación era mágica, casi oracular. Hacías una pregunta y recibías una respuesta con una certeza aplastante. Sin embargo, a medida que pasaron los años y la “luna de miel” con la inteligencia artificial generativa se desvaneció, los usuarios comenzamos a notar las grietas en la fachada: las alucinaciones, los sesgos sutiles y, sobre todo, la confianza injustificada con la que los modelos presentaban datos erróneos.

Hoy, en febrero de 2026, el panorama ha cambiado radicalmente. Ya no nos conformamos con una respuesta rápida; exigimos precisión verificada. En este contexto de madurez tecnológica, Perplexity ha lanzado una herramienta que promete redefinir nuestra relación con la verdad algorítmica: el Model Council (Consejo de Modelos). Esta función no es simplemente una actualización más en la carrera armamentística de la IA; es un cambio de paradigma que reconoce que ningún modelo individual —por muy avanzado que sea— posee el monopolio de la razón.

El concepto detrás del Model Council ataca directamente el problema de la “caja negra” singular. En lugar de confiar ciegamente en GPT-5.2 o en Claude Opus 4.6 por separado, Perplexity propone una arquitectura de consenso. Imagina tener una junta directiva de expertos donde cada uno ofrece su perspectiva antes de redactar el informe final. Eso es exactamente lo que hace esta tecnología: democratiza la inferencia técnica para ofrecer una síntesis más robusta y menos propensa a errores individuales.

¿Qué es exactamente el Model Council?

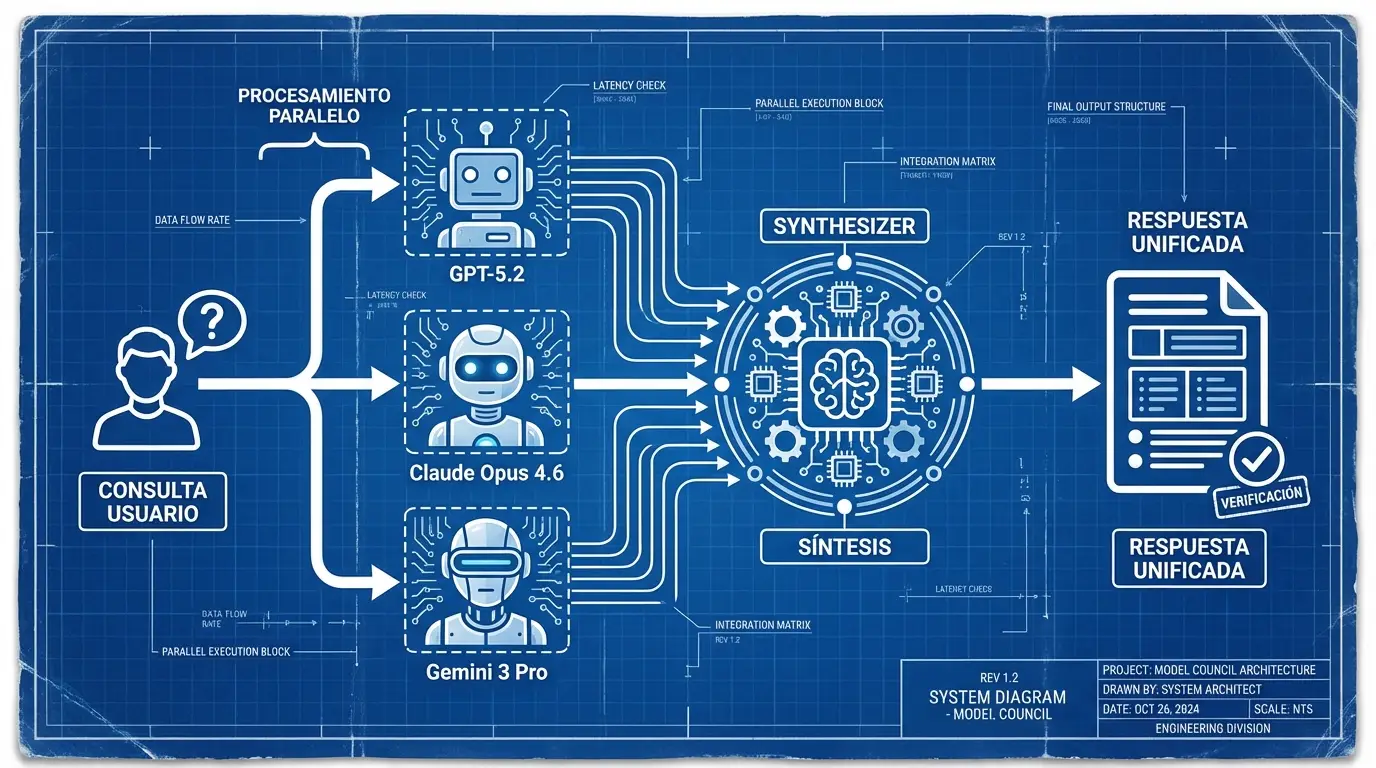

El Model Council es una función avanzada de investigación, disponible para los suscriptores de Perplexity Max y Enterprise Max, diseñada para ejecutar una misma consulta a través de tres modelos de inteligencia artificial de frontera simultáneamente. A diferencia de los selectores de modelos tradicionales, que obligan al usuario a elegir un “motor” antes de empezar (como quien elige entre gasolina o diésel), el Model Council activa tres motores al mismo tiempo.

Según la documentación oficial lanzada por la compañía, el sistema no se limita a mostrar tres columnas de texto una al lado de la otra —lo cual sería cognitivamente abrumador para el usuario—, sino que emplea un modelo sintetizador propietario. Este cuarto componente actúa como un moderador: lee las tres respuestas generadas, identifica los puntos de convergencia (donde los modelos están de acuerdo) y, lo más importante, señala las discrepancias o matices únicos que aporta cada uno.

El resultado final es una respuesta unificada, estructurada y verificada por triangulación. Si GPT-5.2 afirma que una acción subió un 3%, pero Gemini 3 Pro indica que bajó, el Model Council no oculta esta contradicción; la expone. Esto transforma la experiencia de búsqueda: pasamos de recibir una “verdad” a recibir un “análisis de consenso”. Para los profesionales que dependen de la precisión de los datos, esta distinción es vital.

La mecánica detrás de la síntesis: cómo funciona

El funcionamiento técnico del Model Council es un ejercicio de orquestación de alta latencia y alto cómputo. Cuando un usuario introduce un prompt complejo —por ejemplo, una solicitud de análisis sobre la viabilidad legal de una patente en múltiples jurisdicciones—, el sistema de Perplexity fragmenta la petición y la envía en paralelo a los proveedores de inferencia seleccionados.

En la configuración actual de 2026, los modelos involucrados suelen ser los pesos pesados de la industria:

- GPT-5.2 (OpenAI): Conocido por su razonamiento lógico y capacidad de codificación superior.

- Claude Opus 4.6 (Anthropic): Valorado por su redacción matizada y ventanas de contexto masivas, ideales para analizar grandes volúmenes de documentos.

- Gemini 3 Pro (Google): Especializado en la recuperación de datos en tiempo real y multimodalidad.

Una vez que estos tres sistemas generan sus salidas independientes (Raw Outputs), entra en juego la capa de síntesis de Perplexity. Este proceso es crítico y delicado. El sintetizador debe ser agnóstico; no puede tener un sesgo hacia uno de los modelos subyacentes. Su tarea es realizar un análisis semántico comparativo. Busca entidades nombradas (fechas, nombres, cifras) y verifica si coinciden en las tres versiones.

Si los tres modelos coinciden en que “La Revolución Francesa comenzó en 1789”, el dato se trata como un hecho consolidado de alta confianza. Sin embargo, si Claude ofrece un matiz sobre las causas económicas que GPT omite, el sintetizador integra ese matiz en la respuesta final con una atribución clara. Según explica la publicación oficial del blog de Perplexity, este enfoque permite “superficializar los puntos ciegos” que cualquier modelo individual podría tener.

La interfaz de usuario: visualizando el disenso

Uno de los aspectos más interesantes del diseño de producto es cómo se presenta esta información. Perplexity ha optado por no abrumar. La respuesta principal es legible y coherente, pero incluye indicadores visuales —a menudo en forma de tablas o notas al pie expandibles— que muestran el desglose por modelo. El usuario tiene la capacidad de desplegar las pestañas individuales para leer la respuesta “cruda” de cada IA si desea auditar el proceso de síntesis.

Por qué es necesario: la crisis de la alucinación confiada

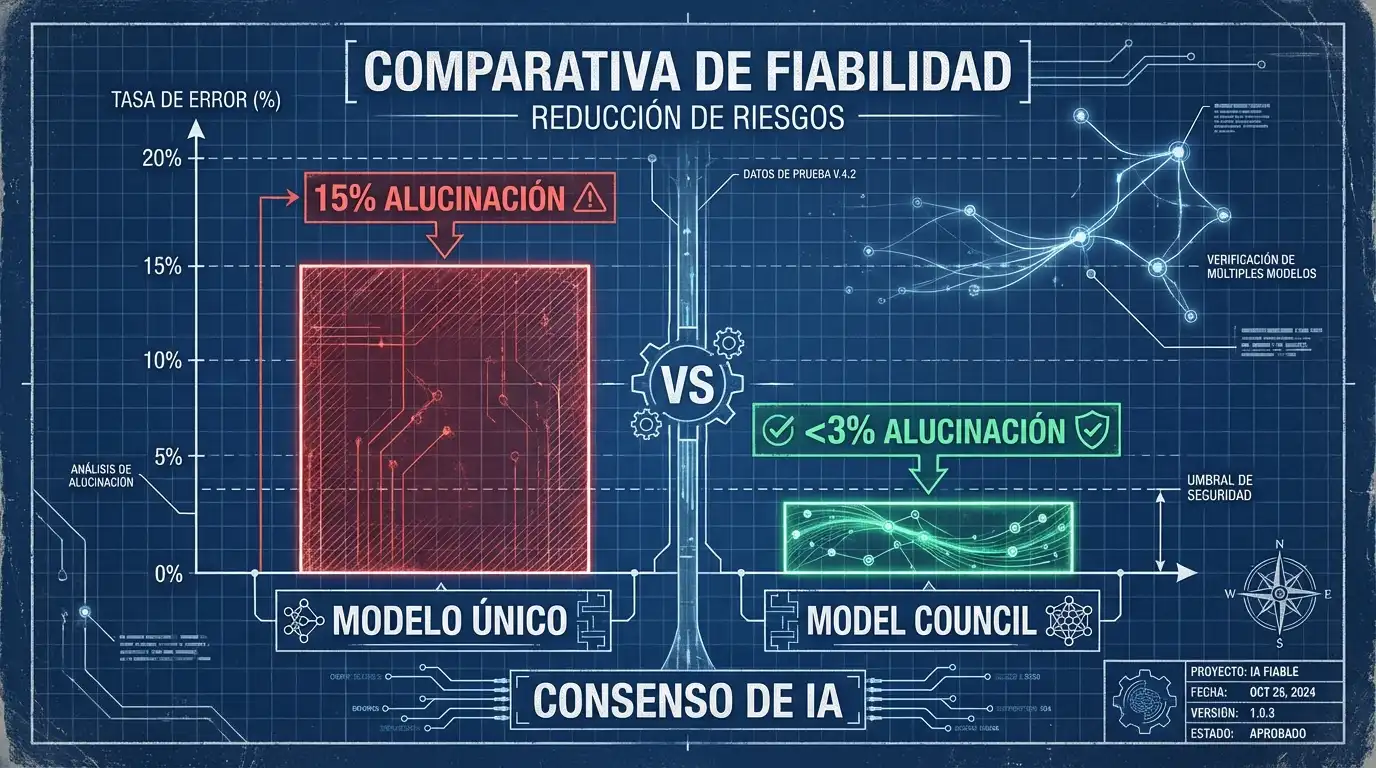

Para entender por qué Perplexity ha invertido tantos recursos computacionales en esta función (ejecutar tres modelos multiplica por tres el coste de inferencia), debemos mirar el contexto histórico de los últimos dos años. Entre 2024 y 2025, la industria se enfrentó a varios escándalos de alto perfil donde abogados, médicos y académicos utilizaron IA generativa que inventó jurisprudencia o diagnósticos con total elocuencia.

El problema no era la falta de conocimiento, sino la arquitectura probabilística de los LLM (Large Language Models). Un modelo predice la siguiente palabra más probable, no la más verdadera. Al introducir el Model Council, Perplexity aplica un principio periodístico básico: la verificación de fuentes. En el periodismo tradicional, una noticia no se publica si no está confirmada por al menos dos fuentes independientes. Perplexity está aplicando este estándar deontológico al software.

Un estudio reciente sobre la fiabilidad de los modelos de IA sugiere que la tasa de error se reduce drásticamente cuando se utiliza una arquitectura de “mezcla de expertos” o votación por mayoría. Si dos modelos dicen “A” y uno dice “B”, la probabilidad de que “A” sea correcto aumenta significativamente, aunque el sistema aún debe alertar sobre la disidencia de “B”.

Casos de uso críticos en el entorno empresarial

La implementación del Model Council no está pensada para preguntas triviales como “¿quién ganó el Mundial de 2010?”. Su valor reside en escenarios de alta complejidad y riesgo, donde el coste del error es elevado. Los primeros adoptantes en el sector empresarial han identificado tres áreas clave donde esta tecnología es indispensable:

1. Investigación Financiera y de Inversiones

En el mundo de las finanzas, un dato incorrecto sobre los ingresos trimestrales de una empresa puede llevar a pérdidas millonarias. Los analistas utilizan el Model Council para contrastar las interpretaciones de los informes de ganancias. Mientras que un modelo puede centrarse en las cifras GAAP, otro podría destacar los riesgos operativos mencionados en la letra pequeña. La síntesis ofrece una visión holística que un solo analista tardaría horas en compilar.

2. Análisis Jurídico y Normativo

Las leyes son interpretables y varían según la jurisdicción. Un modelo entrenado predominantemente con datos de EE. UU. podría alucinar aplicando leyes de Delaware a un caso en Madrid. Al utilizar múltiples modelos con diferentes bases de entrenamiento, el Model Council ayuda a los profesionales legales a identificar posibles conflictos normativos o interpretaciones alternativas de un estatuto antes de redactar un dictamen.

3. Programación y Arquitectura de Software

Aunque parezca contraintuitivo, el código también se beneficia del consenso. Al pedir a tres modelos que generen una solución para un problema de arquitectura de sistemas, es común que uno priorice la seguridad, otro la velocidad de ejecución y el tercero la escalabilidad. El desarrollador puede ver las tres aproximaciones y elegir la más adecuada, o pedir al sintetizador que combine las mejores prácticas de cada una.

El futuro de la búsqueda: de la respuesta a la deliberación

El lanzamiento del Model Council marca el fin de la inocencia en el uso de la inteligencia artificial. Ya no somos usuarios pasivos que aceptan lo que la máquina dice; nos estamos convirtiendo en auditores de la información sintética. Perplexity, al posicionarse no como un creador de modelos (aunque entrena los suyos propios), sino como un agregador neutral y una capa de verificación, está apostando por un futuro donde el valor no está en el modelo en sí, sino en la orquestación de la inteligencia.

Esta estrategia también presiona a los gigantes como Google y OpenAI. Si los usuarios se acostumbran a verificar las respuestas de GPT con Claude en tiempo real dentro de una misma interfaz, la lealtad a una marca específica de IA podría diluirse. La plataforma que ofrezca la mejor síntesis y la mayor transparencia ganará la batalla de la confianza.

Hacia finales de 2026, es probable que veamos esta funcionalidad expandirse. Quizás el próximo paso sea permitir a los usuarios configurar sus propios “consejos”, añadiendo modelos especializados en medicina, leyes o ingeniería a la mezcla. Por ahora, el Model Council es un recordatorio poderoso de que en la era de la información infinita, la verificación es la moneda más valiosa.