El modelo Sora representa un hito significativo en el campo de la generación de video, albergando la capacidad de crear videos de alta fidelidad hasta de un minuto de duración. Este avance se sustenta en un conjunto de innovaciones técnicas y metodológicas clave que abordan tanto la representación unificada de datos visuales para el entrenamiento a gran escala de modelos generativos como la evaluación cualitativa de las capacidades y limitaciones del modelo.

Este documento evalúa la referencia técnica de Sora, un servicio que OpenAI ha prometido que se lanzará en 2024, pero no se ha especificado una fecha exacta. Por el momento, OpenAI ha ido seduciendo a la comunidad con muestras elocuentes de su capacidad para generar video.

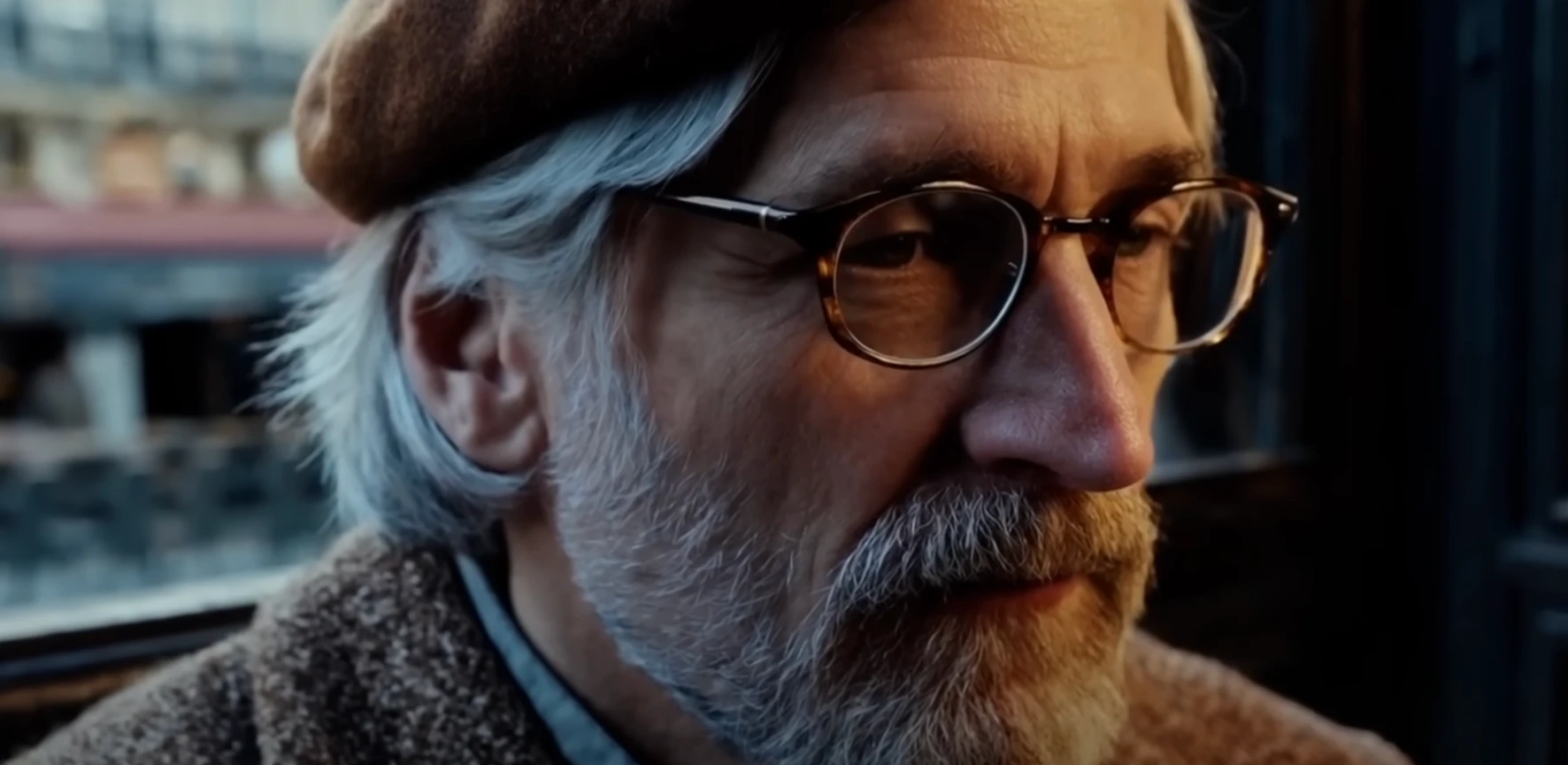

La muestra más reciente de Sora contiene 33 ejemplos de ‘prompts’ con sus respectivos videos generados por inteligencia artificial (IA). En el ‘reel’ se muestra una amplia gama de temas, incluyendo animales en diversas actividades como un canguro danzante y una nutria surfeando, paisajes naturales y urbanos y elementos de fantasía y ciencia ficción como un robot Cyberpunk. También incluye conceptos artísticos y culturales como una muestra de origami y un concepto del Año Nuevo en China.

En una entrevista publicada por The Wall Street Journal, Mira Murati, CTO de OpenAI, resalta que la compañía adopta un enfoque medido para lanzar esta herramienta poderosa, consciente de las preocupaciones éticas y sociales que suscita. Sora se basa en modelos de difusión que analizan una amplia gama de videos para aprender sobre objetos y acciones, permitiendo luego la generación de escenas detalladas a partir de prompts textuales.

Sin embargo, Murati explica que aún existen desafíos técnicos, como la representación precisa del movimiento de las manos, y problemas de continuidad en los videos generados. OpenAI planea incorporar medidas como marcas de agua y metadatos para ayudar a identificar el contenido generado por IA, además de establecer políticas de prompts para evitar el abuso de la herramienta. Entre otros detalles, Sora no permitirá generar videos con figuras públicas o sobre temas sensibles, tal como ocurre en la actualidad con Dall-E, el generador de imágenes.

La fecha de lanzamiento se prevé para finales de 2024. No se han detallado aspectos como sus modelos de membresía, pero Murati explica que el costo de generar 60 segundos de video en Sora es mucho más alto que el costo de generar imágenes con Dall-E. En estos meses, la compañía se concentrará en optimizar esos costos. También se está trabajando para que los videos incluyan audio en algún momento en el futuro.

Lee también: Cómo crear un GPT propio que escriba con tu estilo en ChatGPT Plus

El modelo se entrena utilizando tanto datos públicamente disponibles como datos con licencia, incluyendo material de Shutterstock. Aunque no se especifica si se incluyen videos de plataformas como YouTube, Instagram o Facebook, el modelo de difusión de Sora es capaz de esbozar escenas completas y rellenar cada fotograma basándose en el aprendizaje obtenido de su conjunto de datos de entrenamiento.

La reacción a Sora en la industria ha sido mixta, destacando tanto su potencial para revolucionar la producción de contenido visual como las preocupaciones sobre su impacto en los empleos. Tyler Perry expresó tanto interés por las posibilidades de ahorro que ofrece esta tecnología como preocupación por sus implicaciones, pausando una expansión de su estudio de 800 millones de dólares. Jeanette Moreno King señaló que, aunque la tecnología podría asumir algunas tareas, las decisiones artísticas aún requerirán del toque humano, aunque el futuro de la industria parece incierto. Edward Saatchi ve un futuro en el que podremos generar series completas a partir de un ‘prompt’, lo que podría conllevar a una especie de Netflix impulsado por IA.

Mira Murati de OpenAI reconoce el potencial de Sora para alterar la producción de video pero enfatiza en que su despliegue será lento y cuidadoso. La intención es involucrar a la industria cinematográfica y a los creadores en el desarrollo continuo de la herramienta, buscando equilibrar innovación y ética para asegurar que Sora complemente el trabajo creativo en lugar de desplazarlo.

¿Cómo funciona Sora?

Sora basa su arquictura en la conversión de datos visuales en parches. La idea de convertir datos visuales en parches se inspira directamente en la metodología empleada por los modelos de lenguaje grande (LLM). Estos modelos han demostrado capacidades generalistas excepcionales al ser entrenados en conjuntos de datos a escala provenientes de internet, lo que se logra en parte gracias a la utilización de tokens que unifican diversas modalidades de texto, como código, matemáticas y lenguajes naturales. En el dominio visual, este enfoque se traduce en el uso de parches visuales en lugar de tokens de texto.

Los parches visuales actúan como una representación unificada para el entrenamiento de modelos generativos sobre variados tipos de datos visuales. Esta estrategia se basa en trabajos previos que han demostrado la eficacia de los parches como representación para modelos de datos visuales. Los parches no solo simplifican la representación de datos visuales complejos sino que también permiten escalar el entrenamiento de modelos generativos de manera eficiente.

Proceso de conversión

El proceso de conversión de datos visuales en parches comprende dos etapas principales:

- Compresión de videos en espacio latente: Inicialmente, los videos se comprimen a un espacio latente de menor dimensión. Este paso es crucial para reducir la complejidad y la cantidad de datos a procesar, al tiempo que se preserva la información visual esencial.

- Descomposición en parches de espacio-tiempo: Posteriormente, la representación latente obtenida se descompone en parches de espacio-tiempo. Esta descomposición transforma el video en una secuencia de elementos discretos (parches), que pueden ser procesados de manera similar a como los LLM manejan secuencias de tokens de texto.

Explicado de forma sencilla

Imagina que tienes un libro gigante lleno de dibujos que cuentan una historia, pero el libro es tan grande que no puedes llevarlo contigo. Entonces, decides copiar todos los dibujos en un cuaderno más pequeño, pero solo dibujas las partes más importantes para que la historia siga teniendo sentido. Esto es como comprimir los videos en un espacio más pequeño, guardando solo lo más importante para que aún podamos entender lo que pasa en ellos.

Luego, tomas ese cuaderno y lo cortas en pedacitos más pequeños, cada uno con un pedacito de tu historia. Así, es más fácil para ti compartir partes de la historia con tus amigos, o incluso cambiar el orden si quieres contar la historia de manera diferente. Esto se parece a cuando descomponemos el video comprimido en pequeños parches o piezas, y luego los usamos para construir nuevas historias o videos.

La red de comprensión de video

OpenIA explica que la Red de Compresión de Video se encarga de tomar datos visuales brutos (videos) como entrada y transformarlos en una representación latente comprimida. Esta representación es más manejable en términos de almacenamiento y procesamiento computacional, pero sigue siendo rica en información visual relevante. Al reducir la dimensión tanto temporal (duración del video) como espacial (resolución del video), el modelo puede enfocarse en aprender patrones y características esenciales sin ser abrumado por la gran cantidad de datos iniciales.

Componentes clave

Encoder (Codificador): La primera etapa del proceso involucra un encoder que procesa el video original y lo codifica en un espacio latente. Este paso es crucial para capturar la información visual esencial en un formato más compacto.

Espacio Latente Comprimido: El resultado del encoder es una representación latente de menor dimensionalidad que resume el contenido del video. Este espacio latente es donde Sora realiza gran parte de su aprendizaje y generación, permitiendo manipulaciones eficientes y generación de contenido.

Decoder (Decodificador): Para convertir la representación latente de vuelta al espacio de píxeles original, se utiliza un decoder. Este componente es vital para la generación de videos e imágenes, ya que traduce los latentes generados o modificados por Sora de vuelta a un formato visual comprensible.

Proceso de compresión y descompresión

Compresión: Al recibir un video, la red primero lo comprime utilizando el encoder, reduciendo su dimensión y transformándolo en un conjunto de códigos latentes que encapsulan la información visual del video de manera eficiente.

Manipulación en el espacio latente: Una vez en el espacio latente, Sora puede realizar operaciones de generación y edición sobre estos códigos latentes. Este espacio facilita el aprendizaje y la generación al trabajar con una representación más compacta y manejable.

Descompresión: Para visualizar los resultados de las operaciones de generación o edición, los códigos latentes se traducen de vuelta al espacio de píxeles mediante el decoder, resultando en videos o imágenes generados que pueden ser visualizados y evaluados.

Parches latentes de espacio-tiempo

Los parches latentes de espacio-tiempo son fragmentos de la representación latente de un video, obtenidos tras la compresión de los datos visuales originales. Este proceso implica la descomposición de un video, ya sea en su forma comprimida o directamente desde su estado original, en unidades más pequeñas y manejables, llamadas parches, que abarcan tanto dimensiones espaciales (ancho y alto) como temporales (duración). El proceso consta de los siguientes pasos:

Extracción de parches: A partir de la representación latente del video, se extrae una secuencia de parches de espacio-tiempo. Estos parches contienen información visual y temporal esencial de diferentes partes del video, y funcionan de manera análoga a los tokens en un modelo de lenguaje.

Transformación a tokens del transformer: Cada parche latente se trata como un token individual en la entrada del modelo transformer. Esta analogía permite aplicar técnicas de procesamiento de lenguaje natural (NLP) en el dominio visual, aprovechando la capacidad de los transformers para manejar secuencias de datos.

Manejo de diversidad de datos: Al emplear parches como la unidad básica de procesamiento, Sora adquiere la flexibilidad para entrenar en datos visuales con variaciones significativas en duración, resolución y proporción de aspecto, sin necesidad de uniformizar estos atributos previamente.

¿Qué es un parche latente de espacio-tiempo?

Imagina que tienes un video, el cual es básicamente una larga serie de imágenes (o fotogramas) que se muestran rápidamente para contar una historia o mostrar una escena. Ahora, si quisieras trabajar con este video en una computadora para, digamos, crear algo nuevo a partir de él, te darías cuenta de que los videos son archivos enormes y complejos.

Aquí es donde entran los “parches latentes de espacio-tiempo”. Primero, tomamos este video grande y lo comprimimos, lo hacemos más pequeño, de manera que conservamos solo la información más esencial. Es como cuando empacas para un viaje y eliges llevar solo lo que realmente necesitas.

Luego, cortamos este video comprimido en pequeños pedazos o “parches”. Cada uno de estos parches contiene un trozo del video, con información sobre lo que se ve en el video (espacio) y lo que sucede a lo largo del tiempo (tiempo). Así que, en lugar de lidiar con un archivo de video enorme, terminamos trabajando con muchos pequeños parches que son más fáciles de manejar.

Sora utiliza estos parches para entender y crear nuevos videos. Piensa en ello como un artista que tiene un montón de recortes de diferentes pinturas. Al combinar estos recortes de maneras nuevas y creativas, el artista puede crear una obra de arte completamente nueva. De manera similar, Sora puede tomar estos parches latentes de espacio-tiempo y usarlos para generar nuevos videos basados en las descripciones que le das.

Transformadores y modelos de difusión: una fusión innovadora

Sora es un modelo de difusión que incorpora la arquitectura de los transformadores. Los modelos de difusión trabajan añadiendo ruido a los datos de entrada y aprendiendo a revertir este proceso para recrear la entrada original. Cuando se combina con transformadores, esta técnica se optimiza para el manejo de datos visuales, especialmente videos, que son intrínsecamente más complejos debido a su naturaleza temporal y espacial.

Parches ruidosos: En lugar de trabajar con los datos visuales directos, Sora emplea parches ruidosos como entrada. Estos parches, derivados de la representación latente de los videos o imágenes, sirven como la base para que el modelo aprenda a predecir los parches “limpios” originales.

Prediciendo parches limpios: La capacidad de predecir los parches limpios a partir de los ruidosos permite a Sora generar contenido visual coherente y de alta fidelidad. Este proceso se beneficia significativamente de la capacidad de los transformadores para modelar relaciones complejas en los datos.

¿Qué son los transformadores y modelos de difusión?

Los “transformadores” y los “modelos de difusión” son dos tecnologías avanzadas que usamos en inteligencia artificial para crear cosas nuevas, como videos o imágenes, a partir de simples descripciones textuales. Imagina que los transformadores son como chefs expertos que pueden combinar ingredientes de maneras muy complejas para crear platos deliciosos y sorprendentes, mientras que los modelos de difusión son como artistas que empiezan con un lienzo en blanco y poco a poco añaden detalles hasta crear una obra de arte.

Cuando fusionamos estos dos, básicamente estamos combinando las habilidades del chef y del artista. Primero, el modelo de difusión empieza con algo muy básico o incluso con algo que parece un error (como un borrador muy temprano de un dibujo), y gradualmente lo va refinando, quitando los errores y añadiendo detalles, hasta que emerge una imagen o video claro y detallado.

Los transformadores, por otro lado, se encargan de entender la receta que les damos (nuestro texto descriptivo) y determinar exactamente qué “ingredientes” (o sea, qué elementos visuales y cómo se relacionan entre sí a lo largo del tiempo en un video) deben usarse para seguir esa receta al pie de la letra. Pueden manejar tareas complejas y asegurarse de que todo lo que se genera tenga sentido y se vea bien juntos, como asegurarse de que si describimos una escena de playa, el cielo y el mar interactúen de manera realista y coherente.

¿Qué son los parches limpios y parches ruidosos?

Imagina que quieres enseñarle a un amigo cómo limpiar una habitación muy desordenada, pero en lugar de mostrarle una habitación limpia desde el principio, empiezas con una aún más desordenada. Primero, agregas un poco de desorden extra a propósito (esto serían los “parches ruidosos”) y luego le enseñas cómo quitar cada elemento fuera de lugar hasta que la habitación esté ordenada (los “parches limpios”). Este proceso puede parecer contraintuitivo, pero ayuda a tu amigo a entender no solo cómo debe verse la habitación al final, sino también cómo manejar el desorden.

Sora hace algo similar con los videos e imágenes. En lugar de empezar directamente con el contenido visual en su forma final, Sora comienza con versiones “ruidosas” o imperfectas de lo que quiere crear. Este “ruido” no es literalmente sonido, sino una mezcla de elementos visuales que no deberían estar ahí, como colores y formas que hacen que la imagen se vea desordenada o confusa. Luego, poco a poco, aprende a eliminar este ruido y a mejorar la imagen o el video paso a paso hasta que se vea claro, preciso y exactamente como debería ser según la descripción que se le dio.

La habilidad de Sora para hacer este trabajo de limpieza y refinamiento se basa en su entrenamiento con los transformadores, herramientas de IA muy avanzadas que le permiten entender cómo se relacionan entre sí los diferentes elementos de una imagen o un video. Estos transformadores son como las reglas de limpieza en el ejemplo de la habitación desordenada: le dicen a Sora cómo organizar todo correctamente para que el resultado final sea coherente y de alta calidad.

Entrenamiento en tamaños nativos

A diferencia de los enfoques tradicionales que suelen requerir que los videos se redimensionen, recorten o adapten a un tamaño estándar antes del entrenamiento, Sora se entrena directamente en datos a su tamaño nativo. Esto significa que el modelo aprende a comprender y generar contenido en una amplia gama de formatos, desde videos verticales ideales para dispositivos móviles hasta panorámicas amplias para visualización en pantallas de cine.

Sora puede generar contenido en una variedad de resoluciones y proporciones de aspecto, gracias a su enfoque basado en parches y su capacidad para manipular estos parches de manera flexible durante la generación. La flexibilidad de muestreo de Sora facilita la creación de contenido personalizado para distintos dispositivos y contextos, sin necesidad de posprocesamiento adicional para adaptar el contenido a diferentes formatos.

La formación en aspectos y resoluciones nativas también tiene un impacto positivo en la composición y el encuadre de los videos generados. Al comprender mejor cómo se distribuyen los elementos visuales en diferentes formatos, Sora puede optimizar la colocación y el movimiento de los sujetos y objetos dentro del marco, evitando errores comunes como sujetos parcialmente fuera de vista o encuadres poco naturales.

Sora es como un director de cine inteligente que sabe cómo hacer que cualquier escena se vea bien en cualquier pantalla, asegurándose de que todos los detalles importantes estén visibles y colocados de la mejor manera posible, para que tú disfrutes de la historia sin distracciones o partes faltantes.

Entrenamiento con textos descriptivos

Una pieza central de la habilidad de Sora para comprender y generar contenido basado en texto es su entrenamiento en un amplio conjunto de videos acompañados de descripciones textuales altamente descriptivas. Este enfoque permite al modelo aprender correlaciones profundas entre el contenido visual y las descripciones textuales, mejorando significativamente su capacidad para generar videos que coinciden con los prompts de texto.

Además de utilizar textos descriptivos, Sora se beneficia de la integración con modelos de lenguaje como GPT para transformar prompts de usuario cortos, y posiblemente vagos, en descripciones detalladas. Este proceso de ampliación ayuda a proporcionar a Sora un contexto más rico y detallado para la generación de video, permitiendo una interpretación más precisa y completa del prompt.

Capacidad de respuesta a inputs visuales

Además de interpretar y generar contenido basado en descripciones textuales, Sora tiene la habilidad de ser instigado con inputs visuales. Esto significa que puede tomar una imagen o un segmento de video existente y generar contenido continuo a partir de este punto, adaptándose o extendiendo el contexto visual dado.

Mecanismos clave:

Animación de imágenes estáticas: Sora puede recibir una imagen estática como input y, basándose en esta, generar un video que anime o extienda la escena representada. Por ejemplo, podría animar a una persona retratada en una foto para que realice una serie de acciones, o podría extender el paisaje de una imagen estática en un video que explore el entorno.

Edición y extensión de videos: Similarmente, al proporcionarle un clip de video, Sora puede continuar la narrativa visual, extendiendo el contenido de maneras creativas. Esto puede incluir la adición de nuevos elementos a la escena, la modificación del ambiente o la atmósfera, o incluso la creación de secuencias que sigan lógicamente la acción presentada.

Aplicaciones prácticas

La habilidad de Sora para trabajar con inputs visuales abre un amplio rango de aplicaciones prácticas y creativas, incluyendo:

Edición creativa de contenido: La capacidad de animar imágenes estáticas y extender videos permite a los usuarios y creadores transformar contenido existente de maneras innovadoras, desde la creación de secuencias animadas a partir de obras de arte hasta la extensión de narrativas en clips de video cortos.

Desarrollo de material didáctico y promocional: En el ámbito educativo y promocional, esta funcionalidad posibilita la creación de videos dinámicos a partir de material estático, haciendo más atractiva la presentación de información.

Creación de bucles y videos Infinitos: Sora puede generar contenido que se extiende de manera lógica y coherente, facilitando la creación de videos que bucleen suavemente o que, teóricamente, podrían continuar indefinidamente.

Implicaciones para la industria creativa

La capacidad de Sora para interpretar y generar a partir de inputs visuales tiene implicaciones significativas para la industria creativa, ofreciendo nuevas herramientas para la conceptualización y producción de contenido visual.

Agilización de la producción: Esta capacidad puede reducir significativamente el tiempo y los recursos necesarios para producir contenido visual atractivo, al permitir a los creadores transformar y reutilizar material existente de maneras novedosas.

Exploración creativa: Ofrece a los artistas y diseñadores una nueva dimensión de creatividad, al permitirles experimentar con la transformación de imágenes estáticas en narrativas visuales animadas o con la extensión de historias contadas a través de videos.

Personalización de contenido: Para las marcas y empresas, la habilidad de adaptar y personalizar contenido visual de manera rápida y eficiente abre nuevas posibilidades para campañas de marketing dirigidas y dinámicas.