Diversos medios especializados, entre ellos iPullRank y Search Engine Journal (SEJ), han venido publicado información relativa a la filtración de datos de una API de Google Search. Según SEJ, los documentos fueron obtenidos por Erfan Azimi, CEO de la agencia de marketing digital EA Eagle Digital.

El consenso general es que la mayoría de datos encontrados en los documentos filtrados cuestionan las declaraciones de voceros y representantes de Google con respecto a los factores que son, o no son, relevantes para lograr una mejor posición en los resultados de búsqueda de Google.

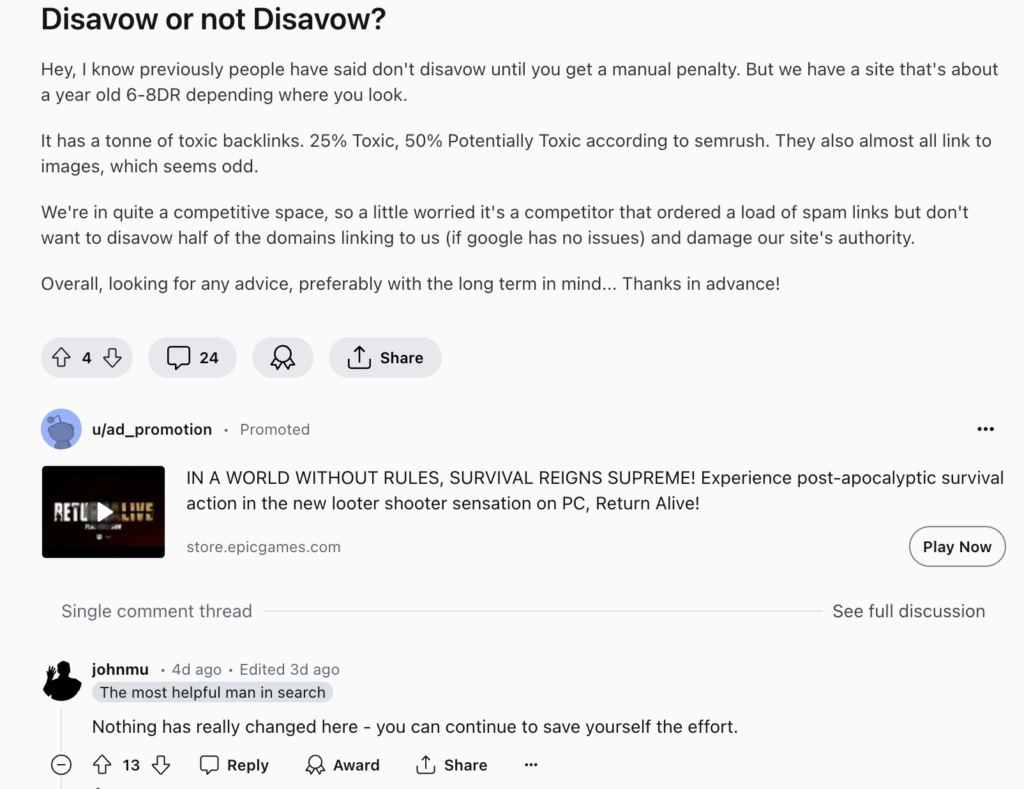

Se ha convertido en lugar común que representantes de Google como John Mueller dediquen su tiempo libre a rebatir los hallazgos de los expertos en SEO que buscan, a través de la experimentación y de la analítica, hallar luces para comprender el intrincando modelo de operación del sistema de clasificación de resultados de Google. Si en algún momento un experto declara que los ‘backlinks’ siguen siendo relevantes para lograr una mejor posición, Mueller suele aparecer con una respuesta jocosa donde desmiente su relevancia.

Un ejemplo de ello fue esta publicación de Reddit donde Mueller invitó a no desgastarse usando la herramienta de desautorización de enlaces (disavow):

Más allá de ello, la filtración no solo parece confirmar que muchos factores técnicos siguen teniendo peso, sino que da luces sobre cómo operan y cómo los podemos usar a nuestro favor. Sin embargo, Search Engine Journal hace varias advertencias válidas:

1. Sin una confirmación directa de Google, la autenticidad de la información filtrada sigue siendo debatible. Google aún no ha comentado públicamente sobre la filtración.

2. La información no está completamente verificada y carece de contexto. Sacar conclusiones definitivas en esta etapa es prematuro.

3. Los algoritmos de clasificación de Google son complejos y están en constante evolución. Incluso si es totalmente precisa, esta filtración solo representa una fotografía en el tiempo.

El 30 de mayo, se conoció una declaración atribuida a Google acerca el tema. En la misma, el gigante de las búsquedas manifestó:

“Recomendamos tener cuidado con las suposiciones inexactas sobre el motor de búsqueda basados en información descontextualizada, desactualizada o incompleta”.

“Hemos compartido información extensa sobre cómo funciona el motor de búsqueda y los tipos de factores que nuestros sistemas consideran, al mismo tiempo que trabajamos para proteger la integridad de nuestros resultados contra la manipulación”, concluye la declaración.

Más allá del debate alrededor de si Google no ha contado toda la verdad en sus declaraciones públicas (me parece lógico que no quieran revelar de forma clara la fórmula de un algoritmo -o un conjunto de algoritmos- que son el núcleo de su negocio central: el motor de búsqueda) en este artículo exploraré las principales conclusiones técnicas que arrojan los documentos filtrados y qué significan para el quehacer de los especialistas SEO en su día a día.

Lee también: Análisis a los factores de ranking SEO filtrados en el código de Yandex

El comportamiento de los usuarios después del clic importa

Para resumirlo de forma sencilla: existe un módulo llamado NavBoost que parece clasificar los clics que reciben un sitio web en “clics malos”, “clics buenos” y “clics largos”.

No queda claro qué es “bueno” o “malo”, pero la documentación da indicios de que un “clic largo” conlleva a un mejor posicionamiento. Esta métrica podría conectarse con el “tiempo de permanencia” de Google Analytics. En otras palabras: si un usuario busca información sobre un tema de su interés, le da clic a un enlace de tu sitio y permanece en la página por mucho tiempo -no queda claro cuántos segundos pero podríamos asumir que, al menos, un minuto- esto es un indicador de calidad y conlleva a una mejor ubicación en los resultados.

También, si un enlace de los resultados comienza a recibir muchos clics, terminará subiendo puestos en los resultados de búsqueda de una ‘query’ o ‘palabra clave’ específica.

No se trata de un dato menor, aunque tampoco es revelador. Quienes hemos trabajado en SEO hemos constatado que un contenido que está teniendo un alto nivel consulta y de permenancia suele ir escalando posiciones en los resultados asociados a las palabras clave objetivo.

El consejo es claro: crea contenido cuyo título esté conectado con el contenido y asegúrate de que la experiencia en la página sea óptima. Si el sitio es difícil de navegar o de leer, esto incidirá negativamente en tu posicionamiento.

A lo anterior se suma que, al parecer, Google usa datos de Chrome para determinar la relevancia de una página. No es algo a lo que le vea relevancia para el SEO, pero es un detalle que ha generado debate porque Google ha negado hacer uso de estos datos en el pasado.

Hay un tiempo de espera para páginas nuevas

Los especialistas SEO hablan de la existencia de una caja de arena o ‘sandbox’ que pone en espera a las páginas web nuevas. Esta filtración parece confirmar su existencia.

En efecto, suele ser habitual que cuando lanzamos una página nueva, aparezca en los resultados unas horas después, incluso unos días después. Este periodo parece estar asociado a la existencia de este ‘sandbox’ que retiene las novedades mientras se constata su calidad.

Cuando un sitio web no sufre este fenómeno suele deberse a que su marca y su autoridad están fuera de toda duda. Un ejemplo de ello son los medios de comunicación reconocidos.

Los autores del contenido tienen relevancia

Todo indica que existe un rastreo constante de los autores del contenido por parte de Google. Entre mayor autoridad tenga el autor de un contenido, mayor posibilidad tendrá de clasificar en una mejor posición.

Lograr apariciones en medios de comunicación, utilizar schemas de autor y, en definitiva, reforzar la reputación a través de acciones conectadas con las relaciones públicas, puede ser un camino para robustecer el puntaje de un autor determinado.

Invitar plumas reconocidas a escribir en tu sitio web también puede ayudar a impulsar el posicionamiento. Esto explicaría porque las recientes actualizaciones del algoritmo han venido favoreciendo a marcas reconocidas y parecen estar golpeando a medios independientes sin un alto grado de ‘social proof’ o reconocimiento social.

Factores que reducen tu posicionamiento

Google expone varios factores que reducirían el puntaje de un contenido -o de un dominio en su totalidad-. Las descripciones son escuetas, pero revisten interés.

- Inconcordancia entre el texto del enlace y el destino del mismo: Cuando el texto del enlace no tiene relación con el sitio de destino al que enlaza, el enlace pierde puntos. Por ejemplo, si creas un enlace que tiene como anclaje “videojuegos”, pero el destino es un sitio de deportes, tendrá menos valor.

- Insatisfacción con los resultados: Google mide la satisfacción de los usuarios con el resultado de búsqueda basado en la duración de su sesión, y la cantidad de clics o eventos que ejecuta en el sitio. Si un usuario entra y sale de inmediato de la página, porque el contenido no es lo que esperaba o la experiencia de usuario no fue óptima, esto impactará negativamente en su posición en los resultados de búsqueda.

- Reducción de la relevancia de dominios exactos: A finales de 2012, Matt Cutts anunció que los dominios exactos no recibirían tanto valor en la actualidad. En efecto, el documento contiene un apartado donde se redujo la relevancia de ese factor otrora usado por los especialistas SEO para mejorar el posicionamiento de un sitio web.

- Las reseñas de productos de mala calidad, afectadas: Las reseñas de productos de baja calidad parecen haber sido golpeadas por cambios recientes del algoritmo. El documento incluye un apartado al respecto, pero no se detalla cómo funciona.

- Google prefiere páginas enfocadas en una ubicación específica: Hay una indicación de que las páginas “globales” y “super globales” pueden perder relevancia en los resultados. Esto sugiere que Google prefiere mostrar resultados con contenido relevante para la ubicación geográfica del usuario.

Los enlaces de sitios relevantes y actualizados importan

Un resumen de lo expreso en la documentación es que tener enlaces en sitios con contenido actualizado, o en portales con alta autoridad en su nicho temático, es importante.

Esto explica por qué lograr backlinks en sitios web de noticias suele mejorar, de forma significativa, el posicionamiento. ¿Ahora entienden por qué el llamado Digital PR ha ganado relevancia en el universo del SEO?

Google solo usa los últimos 20 cambios para una URL

Google considera un documento como antiguo, pero con modificaciones, si ha sido alterado hasta 20 veces. Si cambias la página más de esas 20 veces, Google la tomará como un contenido nuevo, al parecer.

¿Alguna vez han tenido el problema de que Google no les cambia la fecha del artículo por más que le introduzcan modificaciones a la fecha de publicación? Quizá deban hacerlo más de 20 veces para ver un cambio en la información presentada en el SERP. Es un dato que vale la pena poner a prueba.

Se hereda el PageRank de la página principal

La página principal de tu sitio web tiene un puntaje definido en el buscador a través del sistema PageRank. Este ‘score’ es heredado por todas las páginas nuevas del sitio hasta que dichas páginas tengan la antigüedad suficiente para lograr su propia puntuación.

En pocas palabras: tener una página de ‘home’ fuerte deriva en que todas tus páginas, incluso las nuevas, se clasifiquen mejor en los resultados de búsqueda.

Tener una estrategia de backlinks enfocada en fortalecer la página principal beneficia, también, a las demás páginas.

Destacar links y palabras clave importa

Siguen siendo relevante destacar los enlaces, o algunas palabras clave específicas, con un tamaño de fuente mayor, o diferente, al del resto del texto.

Google no lee todo el contenido

Los documentos filtrados indican que hay un número máximo de tokens (un token es cualquier símbolo o palabra) que puede leer el algoritmo de Google. Esto refuerza la idea de quelos autores deben escribir su contenido más importante al principio.

El contenido corto no es malo

El contenido corto se puntúa por su originalidad. Esto desmiente un criterio clásico: que el contenido debe tener una extensión mínima. No es así. No importa la longitud, importa la originalidad. Si el contenido es corto, pero valioso, se posicionará. Es un fenómeno que ya he constatado con varios clientes y este documento confirma lo observado.

Por otro lado, también hay una puntuación asociada al uso de palabras clave de relleno.

Un título largo no afecta la clasificación

A Google no parece importarle si el título SEO definido supera el número de caracteres visibles en los SERP. Este aspecto técnico no termina afectando la indexación y posterior ubicación en los resultados. Sin embargo, se sigue recomendando que no supere los 60-70 caracteres porque poderlo leer completo sí se ha asociado con un incremento en los clics que recibe por parte de los usuarios.

Actualiza la fecha de tus contenidos

Google está muy enfocado en resultados frescos y los documentos ilustran que las fechas existentes en las páginas son tomadas en cuenta.

Lo mejor es especificar una fecha y ser consistente con ella en los datos estructurados, títulos de página y sitemaps XML. Poner fechas en tu URL que entren en conflicto con las fechas en otros lugares de la página probablemente reducirá el rendimiento del contenido.

Si cambias la fecha dentro del artículo, asegúrate de que el cambio se evidencia también en la url y en los schemas.

Hay puntuaciones definidas manualmente

El documento revela dos factores: un sitio web netamente enfocado en videos recibe un trato diferente. Sin embargo, no se especifican detalles. También, se indica que, en ocasiones, los contenidos reciben una puntuación de calidad por parte de humanos. ¿Cómo se usa esa puntuación? No se especifica.

Google identifica focos temáticos

Google tiene un sistema que define si un contenido que publica un medio se encuentra alejado de su foco temático o no. Esto confirma lo que he constatado con la experiencia: si un medio de nicho busca posicionarse en un nuevo eje temático, debe trabajar en la construcción de un amplio abanico de contenidos para que Google reconozca su autoridad en esa nueva área.

Google va construyendo la autoridad del sitio con respecto a sus principales focos temáticos. Cada foco nuevo requiere un conjunto de acciones para ser reconocido eventualmente.

Conclusión

Si bien no existe claridad con respecto a si los datos filtrados son recientes o no, y deben ser tomados con cautela, la mayoría de detalles revelados por los documentos confirman que la comunidad SEO ha venido aplicando prácticas que sí parecen tener impacto en el SEO.