El desarrollo de GPT-4o Omni por parte de OpenAI incorpora una serie de avances técnicos específicos que potencian su eficiencia y eficacia en el manejo de datos multimodales. Estas innovaciones afectan directamente la arquitectura del modelo, los métodos de entrenamiento y las capacidades específicas de procesamiento de imagen y audio.

La base de GPT-4o es una arquitectura de transformadores, que ha sido ampliamente utilizada en el procesamiento de lenguaje natural. GPT-4o lleva esta arquitectura a un nuevo nivel mediante la implementación de varias mejoras clave.

GPT-4o introduce un enfoque innovador en el escalado de las capas del transformador, permitiendo que el modelo ajuste dinámicamente el número de capas activas según la complejidad de la tarea. Esta flexibilidad resulta en una optimización del uso de recursos computacionales, lo que se traduce en una mejora en la velocidad de procesamiento sin sacrificar la calidad de las respuestas.

Una mejora crucial en GPT-4o es la adaptación de los mecanismos de atención para tratar específicamente con datos multimodales. La implementación de “atención modal cruzada” permite que el modelo administre eficazmente los datos de entrada de diferentes tipos (texto, imagen, audio), seleccionando y priorizando la información más relevante para cada consulta. Este enfoque mejora significativamente la coherencia y relevancia de las respuestas del modelo en entornos multimodales.

GPT-4o utiliza técnicas de vanguardia para maximizar su aprendizaje y adaptabilidad, asegurando que el modelo pueda operar eficientemente en una amplia gama de contextos.

Aprendizaje supervisado y técnicas auto-regresivas

El modelo se entrena usando un híbrido de aprendizaje supervisado y auto-regresivo. El aprendizaje supervisado asegura que el modelo pueda replicar y aprender de respuestas humanas validadas, mientras que el enfoque auto-regresivo le permite predecir secuencias de datos (palabras, píxeles, señales de audio) basándose en la entrada anterior, facilitando un aprendizaje continuo y adaptativo.

Después de las etapas iniciales de entrenamiento, GPT-4o se somete a un proceso de refinamiento utilizando aprendizaje por refuerzo a partir de retroalimentación humana (RLHF). Este método ajusta las respuestas del modelo para alinearlas más estrechamente con las evaluaciones y preferencias humanas, mejorando la precisión y la relevancia en aplicaciones prácticas.

GPT-4o ha sido equipado con funcionalidades avanzadas para manejar eficazmente tanto imágenes como audio, lo que permite una integración sin precedentes de diferentes tipos de datos.

Para el tratamiento de imágenes, GPT-4o incorpora capas convolucionales especializadas, diseñadas para detectar patrones visuales y extraer características relevantes de las imágenes. Estas capas permiten que el modelo realice tareas complejas como el reconocimiento de objetos, la interpretación de escenas y la generación de descripciones detalladas basadas en el contenido visual.

En el ámbito del audio, GPT-4o utiliza técnicas sofisticadas de codificación y decodificación. Estas técnicas transforman las señales de audio en formatos que pueden ser procesados por la red neural y luego reconstruyen el audio a partir de las salidas del modelo. Esto es esencial para funciones como la transcripción precisa de voz, la generación de respuestas habladas y la traducción de audio en tiempo real.

Lee también: Google I/O 2024: los anuncios más destacados en IA

Evaluaciones de rendimiento

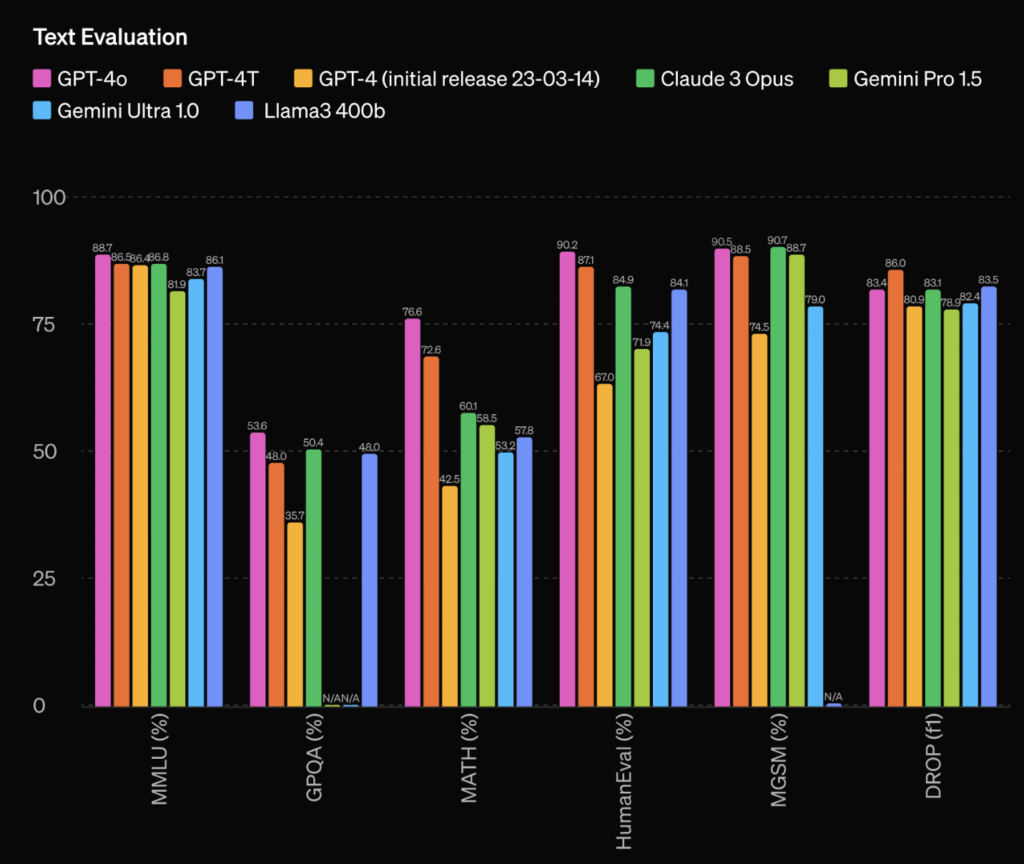

Evaluación de texto (más es mejor)

| Modelo | MMLU | QPQA | MATH | HumanEval | MGSM | DROP |

|---|---|---|---|---|---|---|

| GPT-4o | 88.7 | 53.6 | 76.6 | 90.2 | 90.5 | 83.4 |

| GPT-4T | 86.5 | 48.0 | 72.6 | 87.1 | 88.5 | 86.0 |

| GPT-4 (initial) | 86.4 | 35.7 | 42.5 | 67.0 | 74.5 | 80.9 |

| Gemini Ultra 1.0 | 83.7 | N/A | 53.2 | 74.4 | 79.0 | 82.4 |

| Llama3 400b | 86.1 | 48.0 | 57.8 | 84.1 | N/A | 83.5 |

| Claude 3 Opus | 86.8 | 50.4 | 60.1 | 84.9 | 90.7 | 83.1 |

| Gemini Pro 1.5 | 81.9 | N/A | 58.5 | 71.9 | 88.7 | 78.9 |

GPT-4o se destaca como el modelo más eficaz en la mayoría de las métricas. No solo lidera en MMLU, HumanEval, y MGSM, sino que también muestra fuertes resultados en QQP-A, MATH y DROP. Esta superioridad subraya su capacidad para manejar tareas complejas de razonamiento y comprensión en una variedad de contextos, desde matemáticas hasta comprensión de código y procesamiento del lenguaje natural a nivel humano.

Claude 3 Opus muestra un rendimiento consistente y equilibrado, destacando particularmente en MGSM con un 90.7%, aunque no lidera en otras métricas. Esto sugiere una sólida capacidad de generalización a través de distintos tipos de evaluación.

GPT-4T y Llama3 400b ofrecen rendimientos comparables y sólidos en todas las métricas, con GPT-4T superando ligeramente a Llama3 400b en HumanEval y MGSM, lo cual indica su utilidad en tareas de generación de texto avanzadas y comprensión de lenguaje.

GPT-4 (initial), aunque avanzado en su momento, muestra una deficiencia significativa en MATH y HumanEval comparado con sus versiones posteriores, lo que refleja la evolución y mejora continua en las versiones más recientes de GPT.

Gemini Pro 1.5 y Gemini Ultra 1.0 muestran limitaciones en áreas como QQP-A (donde los datos son aplicables) y MATH, lo que podría indicar debilidades en tareas específicas de entendimiento y generación de lenguaje.

El alto rendimiento de GPT-4o en casi todas las métricas lo hace ideal para aplicaciones que requieren una comprensión profunda del lenguaje y la capacidad de realizar tareas complejas, como sistemas de respuesta automática avanzados, asistentes de codificación inteligente y aplicaciones de educación automatizada.

Los modelos como Claude 3 Opus y GPT-4T también son valiosos por su equilibrio general en todas las métricas, lo que sugiere que pueden ser eficaces en una variedad de aplicaciones, desde traducción automática hasta análisis de texto y generación de contenido.

Pruebas realizadas:

MMLU (Massive Multitask Language Understanding): Esta prueba evalúa la capacidad de comprensión del lenguaje de un modelo en una escala masiva. MMLU incluye múltiples tareas y preguntas que abarcan una amplia variedad de temas y disciplinas, desde ciencias hasta artes y humanidades. Su objetivo es medir la habilidad del modelo para entender y procesar información compleja y variada en forma de texto.

2. QQP-A (Quora Question Pairs – Accuracy): El test de Quora Question Pairs mide la habilidad de un modelo para determinar si dos preguntas formuladas en Quora son semánticamente equivalentes. Es decir, evalúa si dos preguntas distintas buscan en realidad la misma respuesta, lo cual es fundamental para sistemas que buscan eliminar duplicados y mejorar la búsqueda y recuperación de información.

3. MATH: Este test evalúa la capacidad de un modelo de inteligencia artificial para resolver problemas matemáticos. Puede abarcar desde aritmética básica hasta matemáticas más avanzadas, como álgebra y cálculo. Es una prueba importante para determinar la capacidad lógica y numérica de los modelos de IA.

4. HumanEval: HumanEval es una suite de pruebas diseñada para evaluar la habilidad de los modelos de generación de código para completar tareas de programación. Incluye problemas de codificación que los modelos deben resolver generando fragmentos de código funcional. Esta prueba es crucial para evaluar modelos destinados a asistir o automatizar tareas de desarrollo de software.

5. MGSM (Multilingual Global Semantic Model): Aunque no se mencionó “MGSM” en el conjunto de datos inicial, si te refieres a un test general para evaluaciones semánticas multilingües, sería una métrica teórica para evaluar la capacidad de un modelo para entender y generar respuestas en múltiples idiomas, manteniendo coherencia y precisión semántica en todas ellas.

6. DROP (Discrete Reasoning Over Paragraphs): DROP es una prueba que requiere que los modelos de IA realicen tareas complejas de razonamiento sobre pasajes de texto. Estas tareas pueden incluir el uso de números, comparaciones y procesamiento de eventos temporales, evaluando la capacidad del modelo para entender y manipular información detallada contenida en texto narrativo o expositivo.

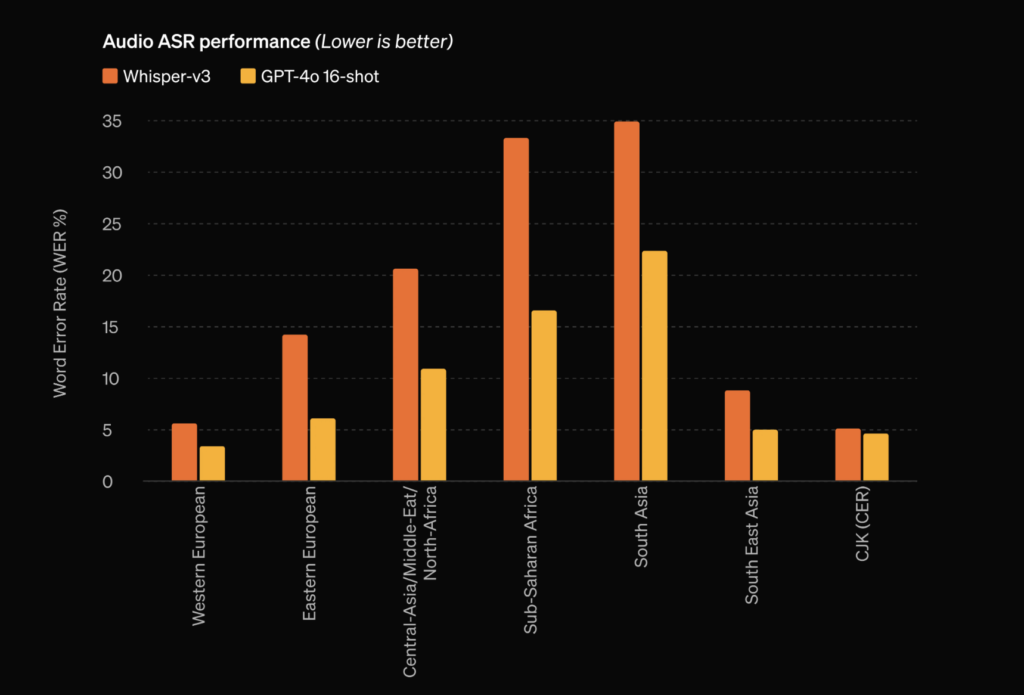

Rendimiento de ASR (menor es mejor)

| Región | Whisper-v3 (%) | GPT-4o 16-shot (%) |

|---|---|---|

| Europa Occidental | 6 | 4 |

| Europa Oriental | 14 | 7 |

| Asia Central/Medio Oriente/Norte de África | 21 | 11 |

| África Subsahariana | 33 | 17 |

| Asia del Sur | 35 | 23 |

| Asia Oriental | 9 | 5 |

| CJK (Chino, Japonés, Coreano) | 5 | 4 |

GPT-4o 16-shot supera consistentemente a Whisper-v3 en todas las regiones analizadas. Esto indica que GPT-4o 16-shot tiene una mejor capacidad para manejar diversos acentos y dialectos, lo que es crucial para aplicaciones globales de reconocimiento de voz.

Europa Occidental y Asia Oriental, que incluyen idiomas como el inglés, alemán y mandarín, muestran los menores índices de error para ambos modelos, pero GPT-4o 16-shot mejora significativamente la precisión en estas regiones. Esto podría indicar un entrenamiento más robusto y un mejor manejo de las variantes lingüísticas comunes en estas áreas.

África Subsahariana y Asia Central/Medio Oriente/Norte de África presentan los mayores errores, lo cual es común dado el alto grado de diversidad lingüística y los retos asociados con la disponibilidad de datos de entrenamiento en estas regiones. Aun así, GPT-4o 16-shot muestra mejoras notables, lo que sugiere avances en la inclusión de estas variantes lingüísticas en su entrenamiento.

Europa Oriental y Asia del Sur también muestran mejoras significativas con el modelo GPT-4o 16-shot. Esto puede reflejar una mayor capacidad del modelo para entender acentos y modismos específicos que son comúnmente mal interpretados por modelos menos avanzados.

La superioridad de GPT-4o 16-shot en estas pruebas de ASR es indicativa de su potencial para aplicaciones en entornos multilingües, como servicios de atención al cliente automático, traducción en tiempo real y asistentes virtuales personalizados.

Las mejoras en regiones con alta diversidad lingüística sugieren que GPT-4o 16-shot podría ser particularmente valioso para empresas y servicios que operan en mercados internacionales, donde la capacidad de manejar múltiples idiomas y dialectos es crucial.

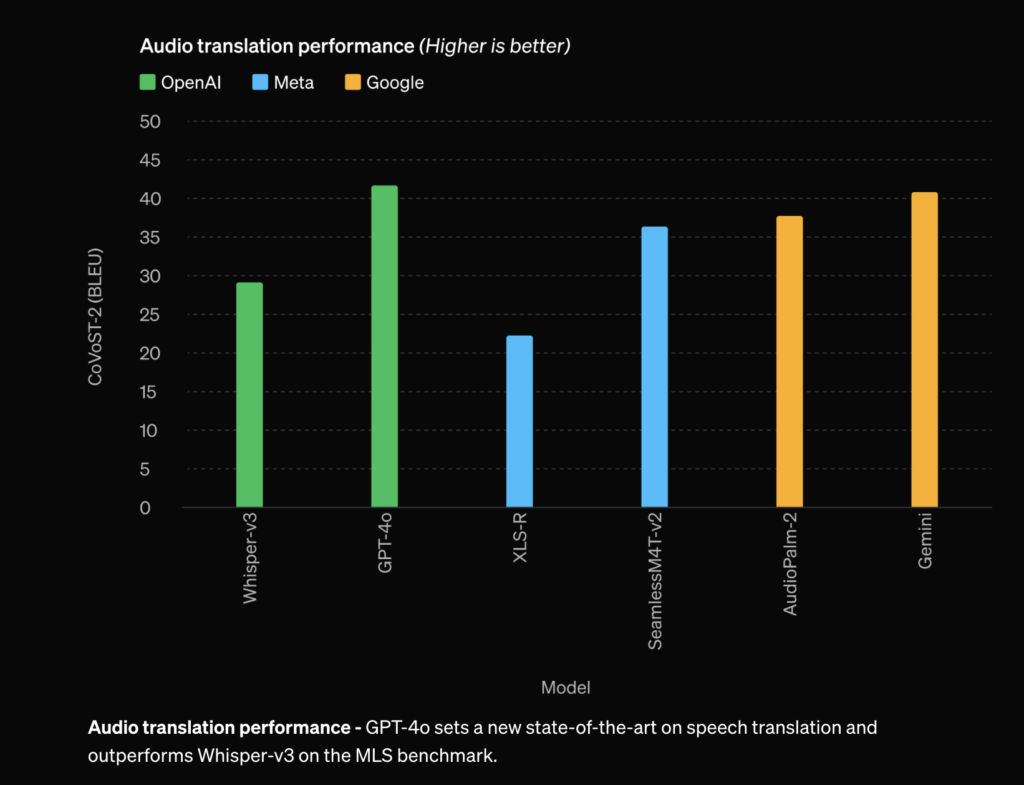

Traducción de audio (mayor es mejor)

| Modelo | BLEU Score |

|---|---|

| Whisper-v3 | 29 |

| GPT-4o | 42 |

| XLS-R | 22 |

| SeamlessMLv4v2 | 36 |

| Audiopalm2 | 38 |

| Gemini | 41 |

GPT-4o se destaca como el líder en rendimiento con un puntaje BLEU de 42, superando a todos los modelos ampliamente excepto a Gemini que se acerca con un puntaje de 41.

Whisper-v3, con un puntaje de 29, y XLS-R, con 22, muestran un rendimiento menor comparado con los modelos más avanzados. Esto indica que tanto Whisper-v3 como XLS-R tienen limitaciones en su capacidad para manejar traducciones de audio complejas.

SeamlessMLv4v2 y Audiopalm2 ofrecen puntajes respetables de 36 y 38, respectivamente, colocándolos como competidores fuertes pero no al nivel de GPT-4o o Gemini.

La eficacia de GPT-4o y Gemini en la traducción de audio los convierte en herramientas valiosas para aplicaciones en entornos multilingües, como plataformas de servicio al cliente, sistemas de navegación global y soluciones de comunicación para entornos multiculturales.

La robustez de GPT-4o y Gemini en este ámbito garantiza que puede ser una opción preferida para empresas y desarrolladores que buscan integrar capacidades avanzadas de traducción en sus aplicaciones, especialmente en sectores donde la interacción precisa y comprensible entre diferentes idiomas es crucial.

Evaluaciones de comprensión de visión

| Evaluación | GPT-4o | GPT-4T 2024-04-09 | Gemini 1.0 Ultra | Gemini 1.5 Pro | Claude Opus |

|---|---|---|---|---|---|

| MMMU (%) (val) | 69.1 | 63.1 | 59.4 | 58.5 | 59.4 |

| MathVista (%) | 63.8 | 58.1 | 53.0 | 52.1 | 50.5 |

| AI2D (%) | 94.2 | 89.4 | 79.5 | 80.3 | 88.1 |

| ChartQA (%) | 85.7 | 78.1 | 80.8 | 81.3 | 80.8 |

| DocVQA (%) | 92.8 | 87.2 | 90.9 | 86.5 | 89.3 |

| ActivityNet (%) | 61.9 | 59.5 | 52.2 | 56.7 | 52.2 |

| EgoSchema (%) | 72.2 | 63.9 | 61.5 | 63.2 | 61.5 |

GPT-4o demuestra ser el modelo superior en todas las categorías de evaluación, logrando consistentemente los puntajes más altos. Especialmente domina en pruebas como AI2D, DocVQA y ChartQA, destacando su capacidad para procesar y entender información compleja visual y textual.

GPT-4T muestra un rendimiento sólido pero generalmente inferior al de GPT-4o, reflejando mejoras significativas en las iteraciones más recientes del modelo.

Gemini 1.0 Ultra y Gemini 1.5 Pro tienen rendimientos más bajos en comparación con GPT-4o en todas las pruebas. Aunque tienen puntajes competitivos en DocVQA, no lideran en ninguna prueba.

Claude Opus también muestra una competencia en varias áreas pero sin liderar en ninguna categoría. Es particularmente fuerte en AI2D, mostrando su habilidad para trabajar con datos visuales.

Descripción de las pruebas

MMMU (val): Evalúa la comprensión del lenguaje a gran escala en múltiples tareas y contextos. Esta métrica es crucial para determinar cómo los modelos generales de AI pueden adaptarse a una amplia variedad de preguntas y problemas.

MathVista: Prueba la capacidad del modelo para resolver problemas matemáticos en un contexto de “mini-examen”, evaluando tanto la precisión como la capacidad de razonamiento numérico y lógico.

AI2D: Evalúa la capacidad del modelo para interpretar y responder preguntas basadas en diagramas y otros datos visuales estructurados, lo que es esencial para aplicaciones que requieren la comprensión de información gráfica.

ChartQA: Similar a AI2D, esta prueba mide la habilidad de un modelo para entender y responder preguntas basadas en gráficos y tablas, un aspecto crítico en muchas aplicaciones empresariales y académicas.

DocVQA: Evalúa cómo los modelos manejan preguntas basadas en documentos visuales, como PDFs o imágenes escaneadas de texto, poniendo a prueba su capacidad para extracción de información visual y textual.

ActivityNet: Se centra en entender y predecir actividades a partir de vídeos, lo cual requiere no solo reconocimiento visual sino también contextual y predictivo.

EgoSchema: Prueba la habilidad del modelo para entender y procesar información desde una perspectiva de “primera persona” o egocéntrica, lo que es útil en aplicaciones como asistentes personales o sistemas de realidad aumentada.