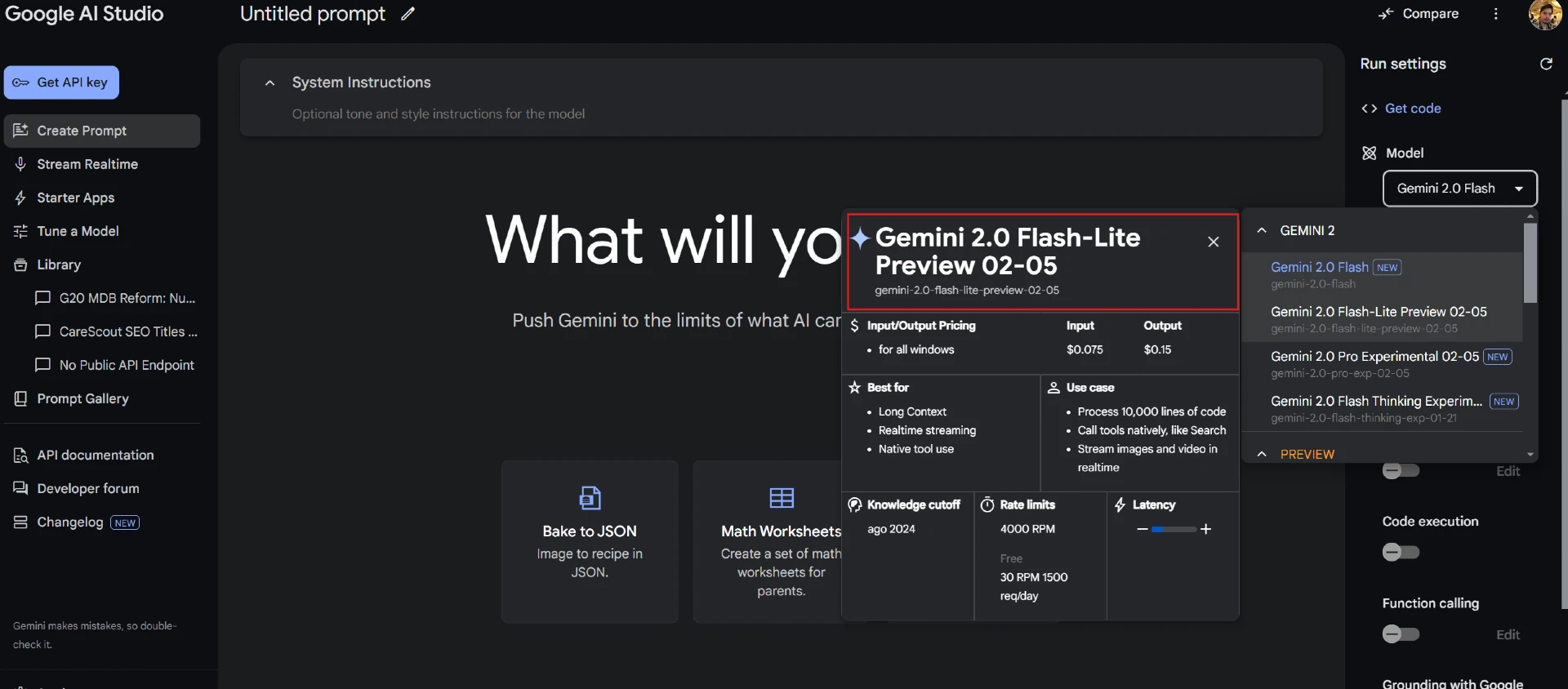

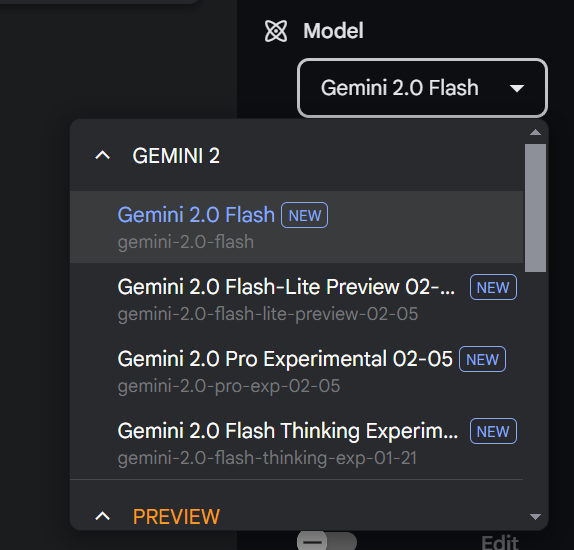

Google ha anunciado la expansión de su suite de modelos de inteligencia artificial Gemini, con actualizaciones que incrementan su disponibilidad y funcionalidades. La compañía confirmó que Gemini 2.0 Flash, presentado inicialmente en fase experimental, ya está accesible de forma general mediante APIs en Google AI Studio y Vertex AI. Este modelo está diseñado para procesar hasta un millón de tokens de contexto, permitiendo el análisis de documentos extensos y datos multimodales. Según la empresa, su rendimiento ha mostrado mejoras en pruebas estándar como LiveCodeBench y MMMU.

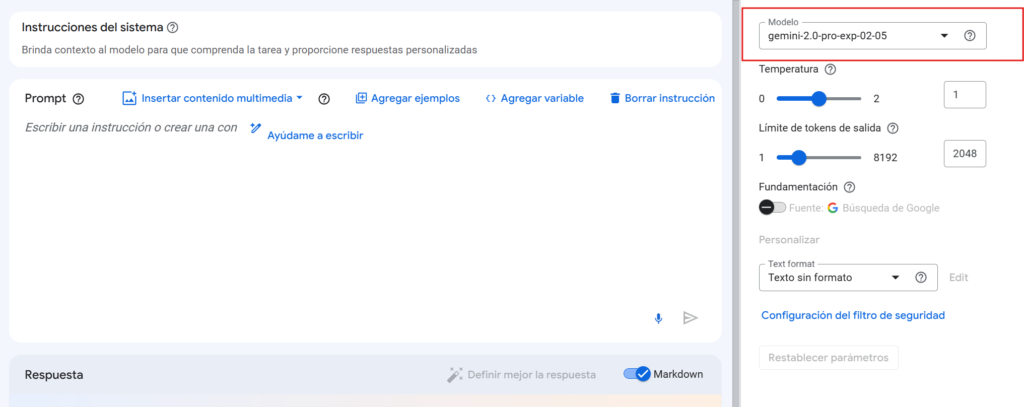

En paralelo, se introdujo una versión experimental de Gemini 2.0 Pro, que amplía la capacidad de contexto a dos millones de tokens. Este modelo integra funciones como ejecución de código y acceso a búsquedas web, orientado a desarrolladores que requieren interacciones complejas. Para usuarios finales, está disponible en la aplicación Gemini Advanced bajo selección manual en el menú de modelos.

Como parte de la actualización, se lanzó Gemini 2.0 Flash-Lite, un modelo enfocado en reducir costos operativos. La compañía indicó que puede generar metadatos para aproximadamente 40,000 imágenes con un costo inferior a un dólar en su modalidad de pago, manteniendo compatibilidad con entradas multimodales y ventanas de contexto de un millón de tokens.

En materia de seguridad, Google mencionó el uso de técnicas de autorrefuerzo donde el modelo evalúa sus propias respuestas, junto con planes para implementar pruebas contra ataques de inyección indirecta de instrucciones.

Los modelos actuales funcionan con entrada multimodal y salida de texto, aunque la empresa anticipa añadir más formatos en los próximos meses. La estructura de precios, disponible en el blog para desarrolladores, sigue un modelo escalable que varía según el volumen de operaciones y complejidad de tareas. La compañía señaló que continúa trabajando en optimizar el equilibrio entre costo, velocidad y precisión, particularmente para aplicaciones que manejan datos sensibles o requieren alto rendimiento en tiempo real.

¿En qué aspectos mejora Gemini 2.0 con respecto a modelos predecesores?

Tabla de métricas de los modelos Gemini (traducida al español)

| Capacidad | Benchmark | Descripción | Gemini Flash | Gemini 1.5 Pro | Gemini 2.0 Flash-Lite (Vista Previa Pública) | Gemini 2.0 Flash (GA) | Gemini 2.0 Pro (Experimental) |

|---|---|---|---|---|---|---|---|

| General | MMLU-Pro | Versión mejorada del conjunto de datos MMLU con preguntas de mayor dificultad en múltiples temas | 67.3% | 75.8% | 71.6% | 77.6% | 79.1% |

| Código | LiveCodeBench (v5) | Generación de código en Python. Subconjunto con ejemplos recientes entre el 01/10/2024 y el 01/02/2025 | 30.7% | 34.2% | 28.9% | 34.5% | 36.0% |

| Bird-SQL (Dev) | Conversión de preguntas en lenguaje natural a SQL ejecutable | 45.6% | 54.4% | 57.4% | 58.7% | 59.3% | |

| Razonamiento | GPOA (diamond) | Conjunto de preguntas desafiantes creadas por expertos en biología, física y química | 51.0% | 59.1% | 51.5% | 60.1% | 64.7% |

| Factualidad | SimpleQA | Evaluación de conocimiento factual sin acceso a búsquedas | 8.6% | 24.9% | 21.7% | 29.9% | 44.3% |

| FACTS Grounding | Capacidad para proporcionar respuestas factuales correctas basadas en documentos y solicitudes diversas | 82.9% | 80.0% | 83.6% | 84.6% | 82.8% | |

| Multilingüismo | Global MMLU (Lite) | Conjunto de datos MMLU traducido por humanos a múltiples idiomas | 73.7% | 80.8% | 78.2% | 83.4% | 86.5% |

| Matemáticas | MATH | Problemas matemáticos desafiantes (álgebra, geometría, precálculo, entre otros) | 77.9% | 86.5% | 86.8% | 90.9% | 91.8% |

| HiddenMath | Problemas matemáticos a nivel de competencia | 47.2% | 52.0% | 55.3% | 63.5% | 65.2% | |

| Contexto Extenso | MRCR (1M) | Evaluación diagnóstica del entendimiento de contextos largos | 71.9% | 82.6% | 58.0% | 70.5% | 74.7% |

| Imagen | MMMU | Comprensión multimodal y razonamiento en problemas multidisciplinares | 62.3% | 65.9% | 68.0% | 71.7% | 72.7% |

| Audio | CoVoST2 (21 lang) | Traducción automática de voz a texto | 37.4% | 40.1% | 38.4% | 39.0% | 40.6% |

| Video | EgoSchema (test) | Análisis de video en múltiples dominios | 66.8% | 71.2% | 67.2% | 71.1% | 71.9% |

Las distintas versiones de los modelos Gemini han evolucionado en términos de capacidades específicas, evaluadas a través de métricas estándar. Las mejoras son evidentes en áreas clave como razonamiento, multilingüismo, matemáticas y manejo de contexto extenso, mientras que otras capacidades, como la generación de código y el procesamiento de audio, muestran avances más moderados.

En términos generales, Gemini 2.0 Pro lidera en la mayoría de las métricas, destacándose como el modelo con el mejor desempeño global. Por ejemplo, en la categoría “General”, evaluada mediante el benchmark MMLU-Pro, este modelo alcanza un 79.1 %, superando tanto a Gemini 1.5 Pro (75.8 %) como a Gemini 2.0 Flash (77.6 %). Este patrón se repite en otras áreas como razonamiento (64.7 %) y matemáticas (91.8 %), donde también logra los mejores resultados.

En contraste, Gemini 2.0 Flash-Lite, diseñado para ser una opción más eficiente en términos de costo, presenta un desempeño competitivo en ciertas áreas, aunque generalmente inferior al de sus contrapartes más avanzadas. Por ejemplo, en el benchmark Global MMLU (Lite), que mide capacidades multilingües, alcanza un 78.2 %, superando a Gemini 1.5 Flash (73.7 %) pero quedando por debajo de Gemini 2.0 Flash (83.4 %) y Gemini 2.0 Pro (86.5 %).

Un área que merece especial atención es la factualidad, evaluada mediante dos benchmarks: SimpleQA y FACTS Grounding. Aunque los modelos más recientes muestran mejoras significativas respecto a versiones anteriores, esta sigue siendo una capacidad con margen para optimización. En SimpleQA, por ejemplo, Gemini 2.0 Pro logra un 44.3 %, un avance considerable frente al 24.9 % de Gemini 1.5 Pro, pero aún por debajo del rendimiento observado en otras categorías.

Lee también: Reseña: pusimos a prueba la integración de Gemini con Google Workspace

Otro aspecto notable es el manejo de problemas matemáticos complejos y contextos extensos, donde los modelos más recientes presentan avances consistentes. En el benchmark MATH, Gemini 2.0 Pro alcanza un 91.8 %, consolidándose como una herramienta robusta para tareas que requieren razonamiento lógico y matemático avanzado.

Por último, las capacidades relacionadas con audio y video muestran un crecimiento más limitado en comparación con otras áreas. En CoVoST2 (21 lang), que evalúa traducción automática de voz a texto, el mejor desempeño corresponde a Gemini 2.0 Pro con un 40.6 %, lo que indica que estas capacidades aún están en desarrollo.

En conjunto, los datos reflejan una estrategia clara por parte de Google para diversificar su oferta según necesidades específicas: desde modelos altamente especializados como Gemini 2.0 Pro hasta opciones más accesibles como Flash-Lite. Sin embargo, las diferencias en desempeño entre capacidades sugieren que algunos aspectos del desarrollo aún requieren atención para alcanzar niveles óptimos de rendimiento en todas las áreas evaluadas.